#7026 天線生日快樂 » 2019-01-02 11:11:49

回应:

![[賣萌]](/forum/img/smilies/haku/haku-cute.svg)

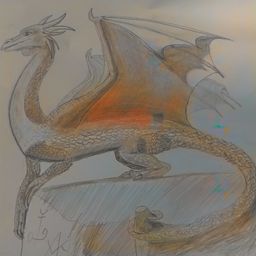

#7027 年末最後一畫 同時是第一畫.. » 2019-01-02 11:10:12

回应:

![[大笑]](/forum/img/smilies/haku/haku-laugh.svg)

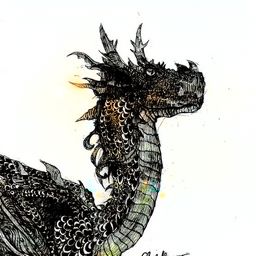

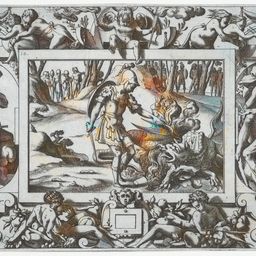

#7028 旭日龍影 » 2019-01-02 11:05:13

回应:

![[靈感]](/forum/img/smilies/haku/haku-idea.svg)

有那個迷你史矛革躺金幣上圖裝(超兇)的感覺

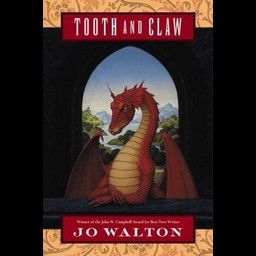

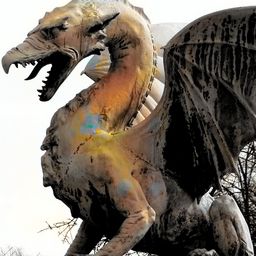

#7029 【文字類遊戲】《Angels with Scaly Wings(鱗翼天使)》 » 2019-01-02 10:59:02

回应:

好消息!簡體中文補丁已經發布在創意工坊,雖仍有較多Bug,但對話文本已經全部翻譯。

總共22小時(部分內容看了攻略),終於艱難的完全通關了,通關的第一個文字遊戲。一週目死了4只龍,簡直不能更慘

首先要說明的是,steam給了《鱗翼天使》一個“心理恐怖”標籤(介紹視頻也能看出端倪),但實際上恐怖程度屬於可接受範圍,和真正的恐怖遊戲不是一個水平。當然了,在得知了某些真相或是打出了某些壞結局後,也不是很讓人舒服的事。

本遊戲有龍死亡的情節。

(心理恐怖是恐怖作品的一種亞類型,是依靠人物的恐懼、內疚、信仰以及怪異的音效、不穩定的情緒來營造緊張氣氛、發展情節。)

遊戲的主線是主角肩負的使命和尋找真相的過程,支線則是和各條龍的“約會”。每條龍都有自己的祕密,而且互有交叉關係。

某些背景設定和臺灣作者小火龍的《人龍紀元》很有異曲同工之妙。但科幻部分確實不太經得起推敲……好在不細想就問題不大。音樂也還不錯,很好的烘托了氣氛。

綜上所述值得一玩,畢竟是獨一無二的題材和類型。

————————————————————————————————————————

@黑龍逐光 還有逐光你的頭像放到http://saucenao.com/這個圖片搜索引擎中可以搜索到有兩個網站收錄了,作者是日本的touto seiro,不過顯示收錄時間是6年前,已經找不到原始出處。

最后修改: 蓝羽龙 (2019-07-11 18:22:21)

有 1 位朋友喜欢这篇文章:龍爪翻書

#7030 龍圖-彩虹小馬篇 » 2019-01-01 21:50:27

#7031 [TensorFlow]pix2pix操作步驟分享 » 2019-01-01 21:31:36

回应:

其實不用那麼麻煩...你可以直接在那個目錄檔案總管上面的路徑欄裡面打cmd他就會開啟小黑窗並自動導向到那個路徑了

成功了,好方便 ![[驚訝]](/forum/img/smilies/haku/haku-suprise.svg)

請容許我吐槽一下這個叫指令不是程式碼

已修改

又學到新知識了 ![[賣萌]](/forum/img/smilies/haku/haku-cute.svg)

還有以programmer的角度來看 從github下載zip是非常不健康的行為

以業餘玩家來說,直接下載ZIP比較直覺、比較簡單

#7032 [TensorFlow]pix2pix操作步驟分享 » 2019-01-01 16:57:15

回应:

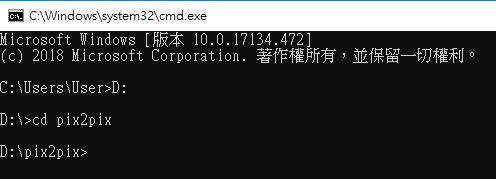

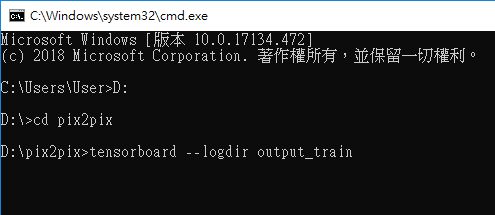

5. 開啟命令提示字元(cmd)

5-1 按windows鍵+R,開啟執行視窗

5-2 輸入cmd,按確定6. 執行pix2pix.py

6-1 切換到D磁碟,輸入D:

6-2 切換到pix2pix資料夾 輸入cd pix2pix

其實不用那麼麻煩...你可以直接在那個目錄檔案總管上面的路徑欄裡面打cmd他就會開啟小黑窗並自動導向到那個路徑了

8-3 驗證圖片程式碼為:

python pix2pix.py --mode test --output_dir output_val --input_dir input_val --checkpoint output_train

請容許我吐槽一下這個叫指令不是程式碼

就這個來說程式碼是指pyhton source file 裡面的 code....還有以programmer的角度來看 從github下載zip是非常不健康的行為

雖然只是call別人的library感覺沒啥意思 不過改天有機會再來玩看看好了

有 1 位朋友喜欢这篇文章:龍爪翻書

#7034 [TensorFlow]pix2pix操作步驟分享 » 2019-01-01 12:33:00

回应:

安裝好TensorFlow,而且裁切好訓練用圖片後,就可以開始用pix2pix進行學習了

以下分享我的操作步驟

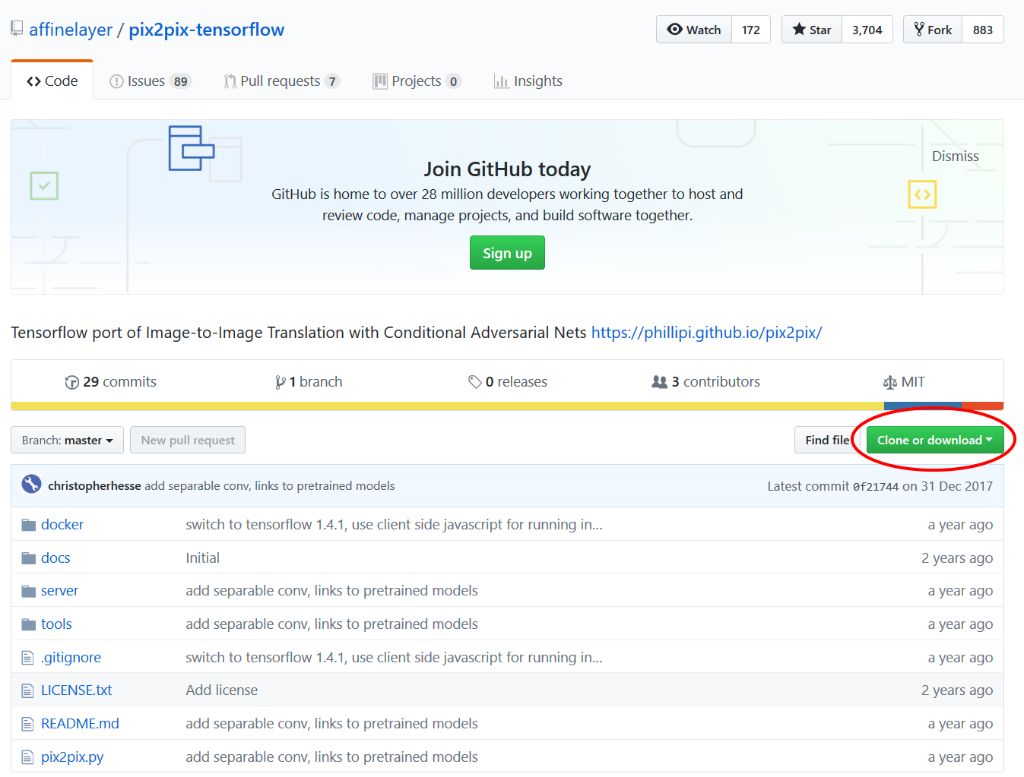

1. 下載pix2pix.py

1-1 到這個網址

https://github.com/affinelayer/pix2pix-tensorflow

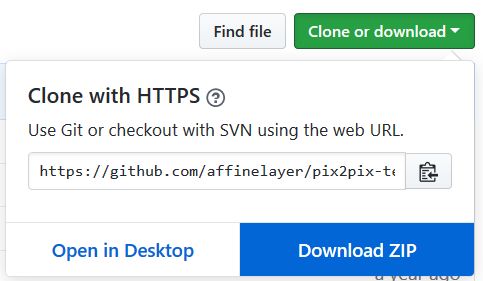

1-2 按「Clone or download」

1-3 按「Download ZIP」

2. 解壓縮ZIP

2-1 將下載好的pix2pix-tensorflow-master.zip 解壓縮

2-2 裡面的pix2pix.py 是我們需要的

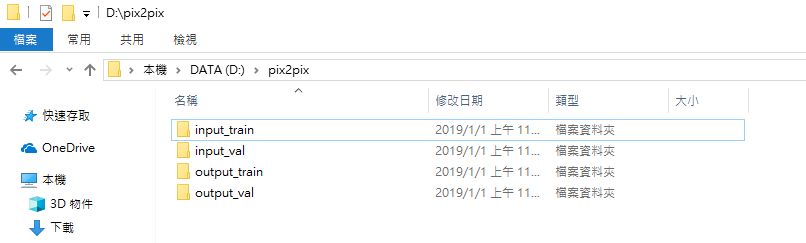

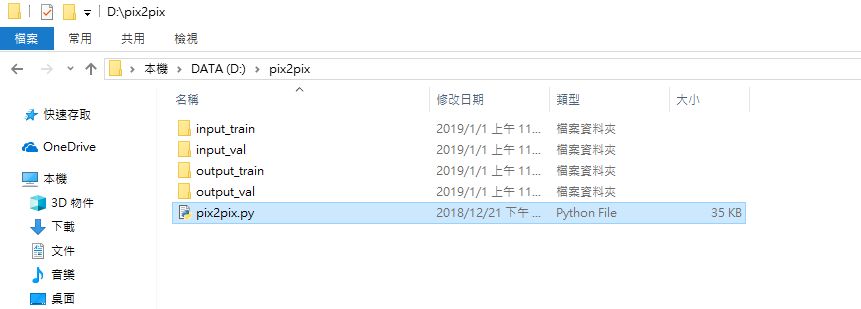

3. 設定資料夾名稱和結構

3-1 我的作法,在D磁碟中新增pix2pix資料夾

3-2 在pix2pix資料夾中,新增input_train、input_val、output_train、output_val 四個資料夾

備註:val是validation(驗證)的簡稱

4. 複製檔案

4-1 將pix2pix.py複製到pix2pix資料夾中

4-2 將訓練用的圖片放到input_train中

4-3 將驗證用圖片放到input_val中

5. 開啟命令提示字元(cmd)

5-1 按windows鍵+R,開啟執行視窗

5-2 輸入cmd,按確定

6. 執行pix2pix.py

6-1 切換到D磁碟,輸入

D:6-2 切換到pix2pix資料夾 輸入

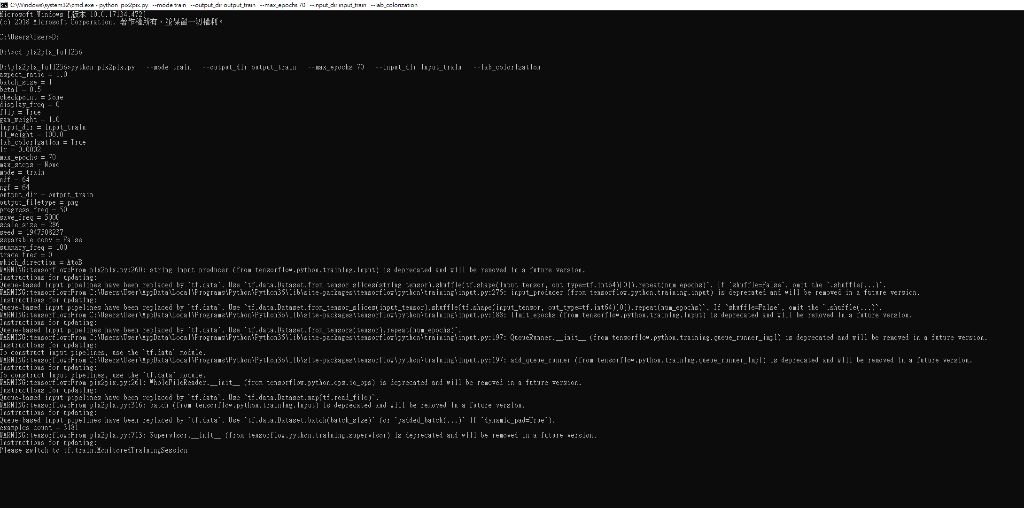

cd pix2pix6-3 執行pix2pix.py,輸入

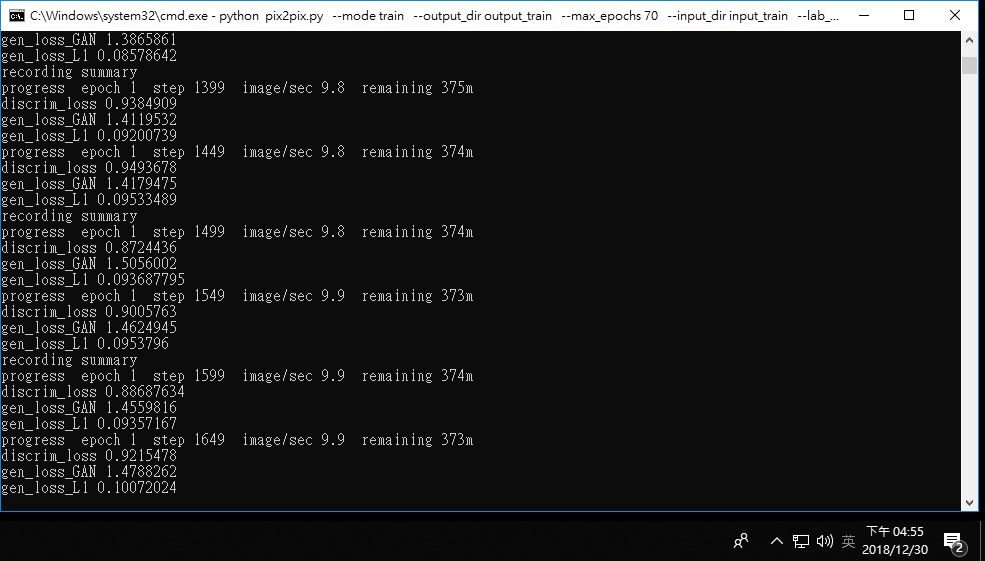

python pix2pix.py --mode train --output_dir output_train --max_epochs 70 --input_dir input_train --lab_colorization備註:指令中的輸入、輸出資料夾名稱要和上面設定的相符。max_epochs 70 我看有人設200,聽說圖片樣本少可以設200,圖片樣本多可以低一些。

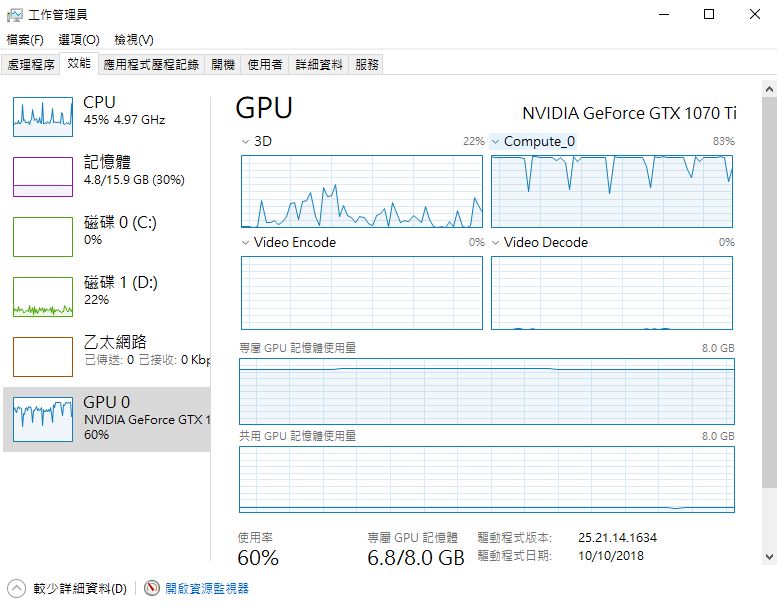

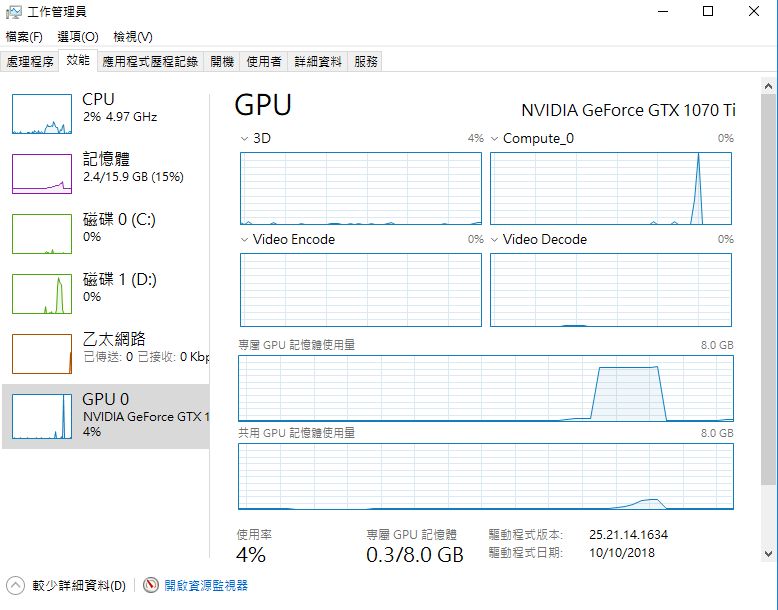

成功執行的話,CPU和GPU都會飆高(以tensorflow-gpu版本來說)

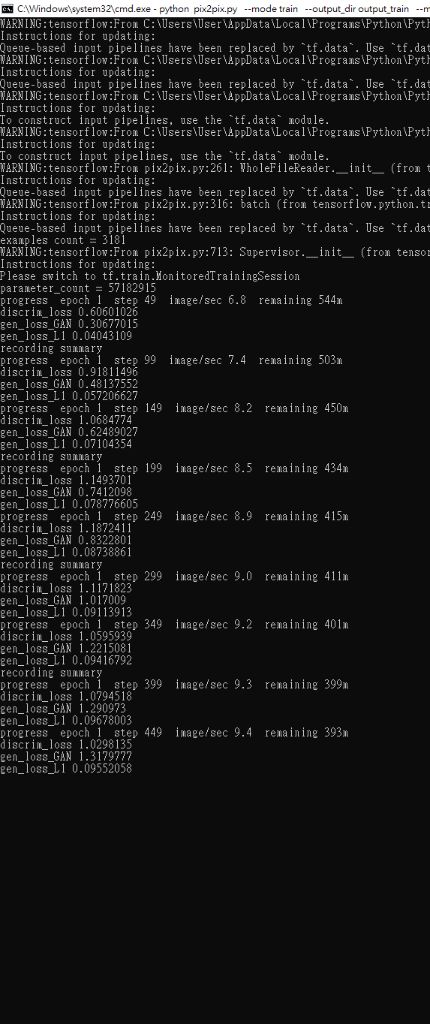

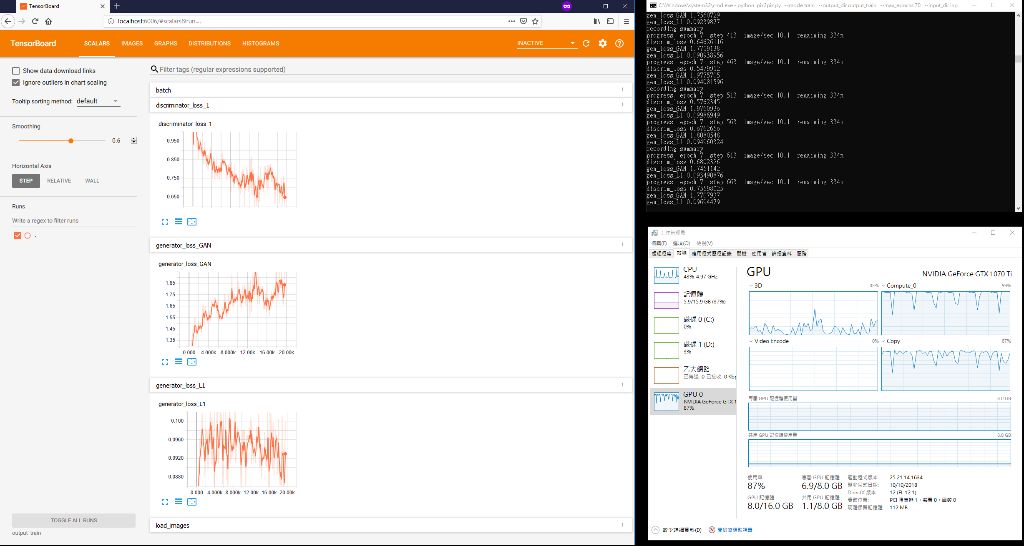

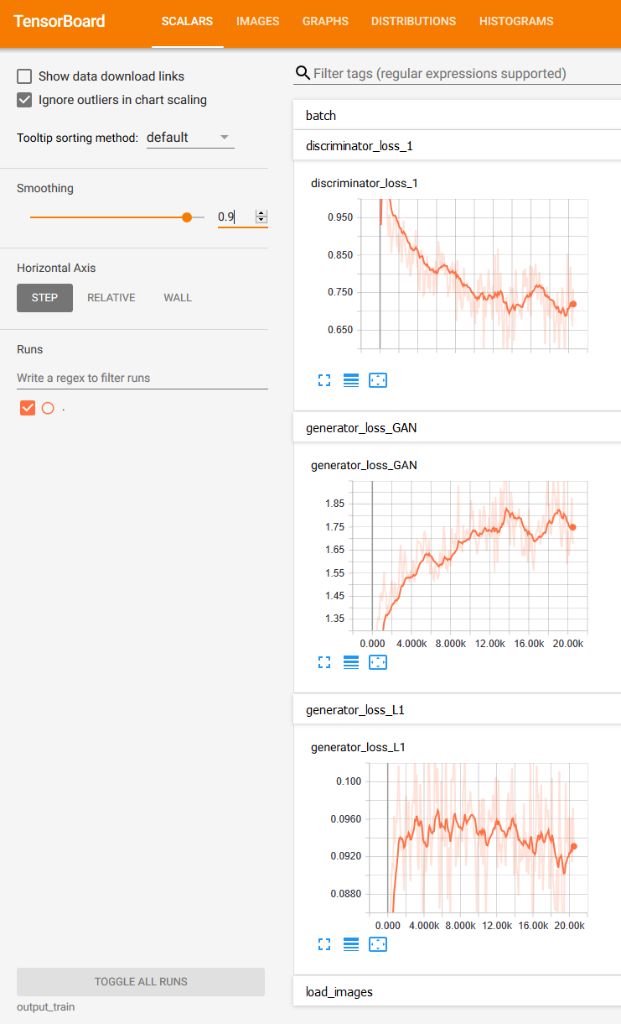

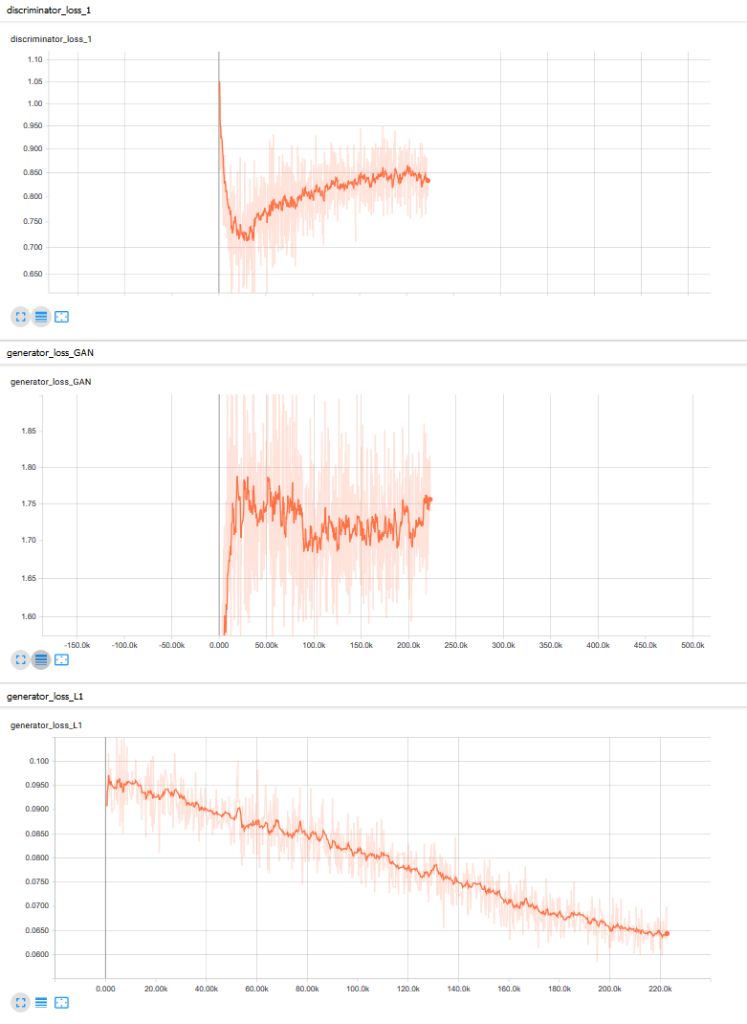

7. 檢視訓練進度

7-1 按windows鍵+R,輸入cmd,按確定,再開啟一個cmd。這不會中斷正在進行訓練的cmd。

7-2 切換到pix2pix資料夾。

輸入

D:

輸入

cd pix2pix7-3 啟動tensorboard。

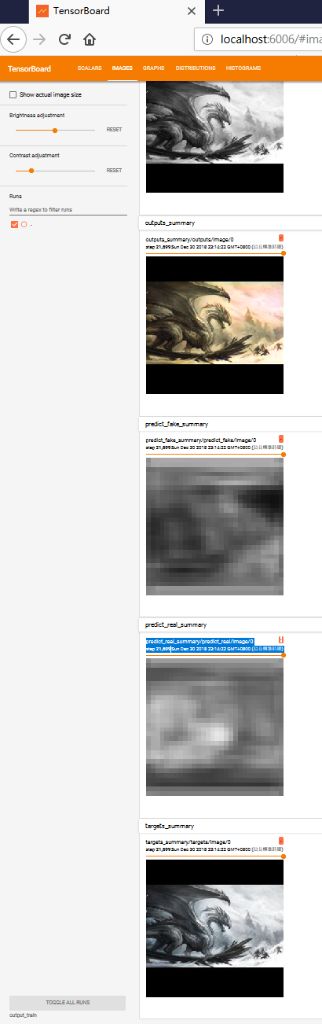

tensorboard --logdir output_train備註:tensorboard 是 TensorFlow提供的視覺化工具,可以方便的觀察loss的變化

7-4 啟動瀏覽器,網址輸入

http://localhost:6006

7-5 scalars 分頁,可以看到loss曲線

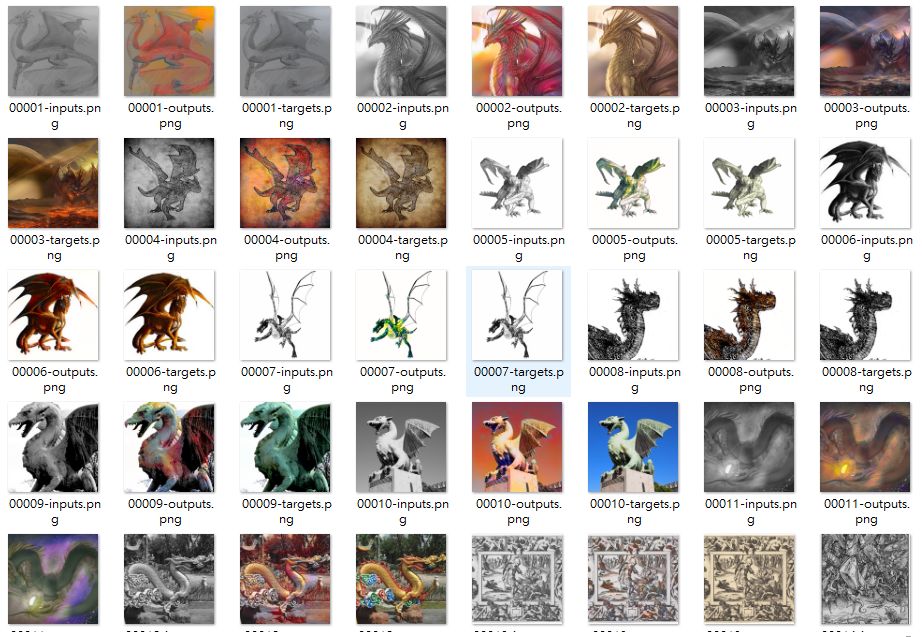

7-6 images分頁,可以看到訓練過程中,圖片被上色的樣子

8. 訓練完成後,用圖片進行驗證

8-1 按windows鍵+R,輸入cmd,按確定,開啟一個cmd。

8-2 切換到pix2pix資料夾。

輸入

D:

輸入

cd pix2pix8-3 驗證圖片指令為:

python pix2pix.py --mode test --output_dir output_val --input_dir input_val --checkpoint output_train8-4 之後output_val會出現圖片資料夾和一個html網頁,我之前分享的html就是這樣來的,我覺得這種網頁格式蠻方便分享的。

----------

附錄1、第7步驟的圖片

最后修改: 龍爪翻書 (2019-01-01 21:27:35)

有 1 位朋友喜欢这篇文章:小契

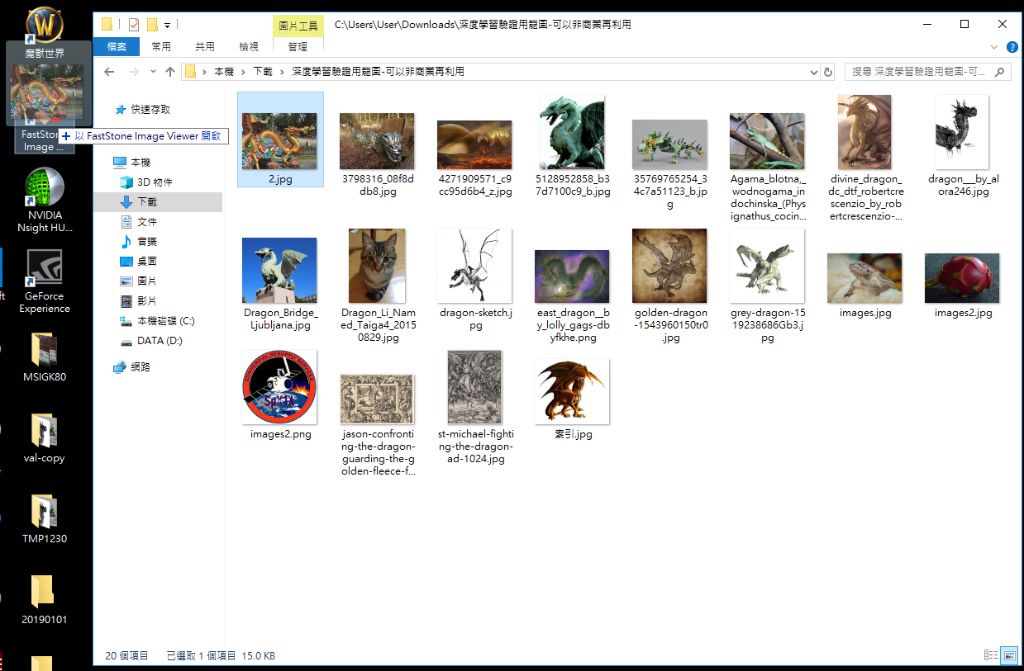

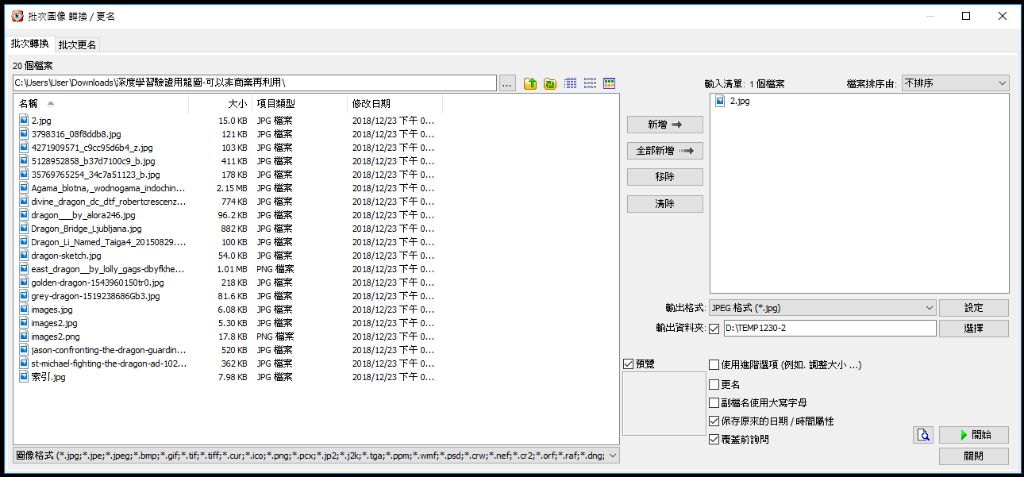

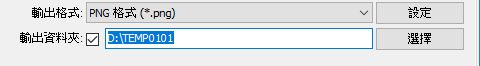

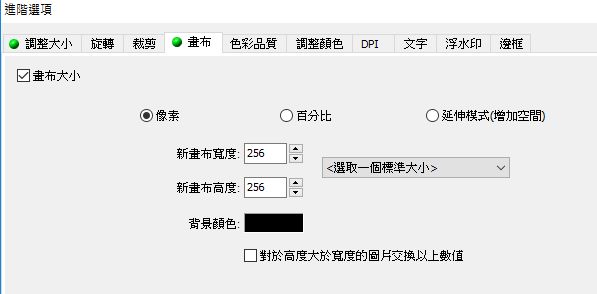

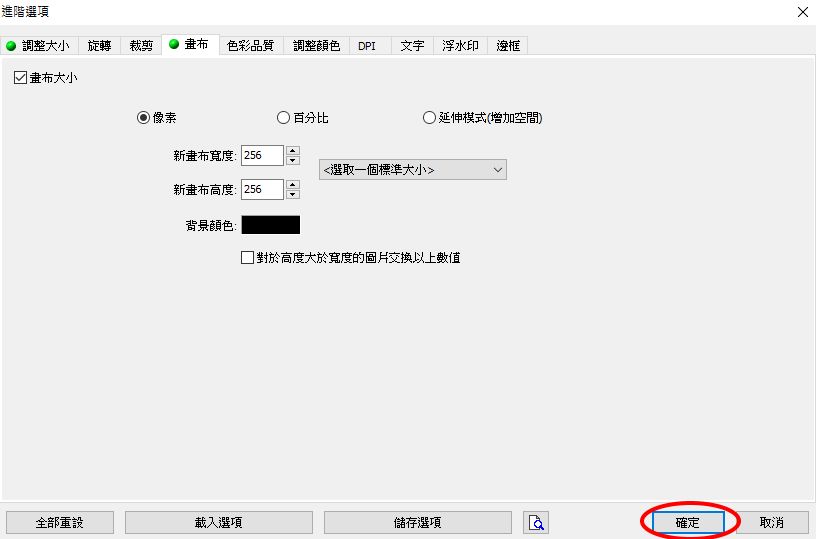

#7035 FastStone Image Viewer 批次壓縮圖片、調整大小,操作步驟分享 » 2019-01-01 11:38:27

回应:

以目前的電腦硬體來說,深度學習非常吃資源,所以深度學習訓練用的圖片通常都不大

例如用深度學習辨識手寫數字,MNIST裡面的範例圖片,是28*28畫素

我最近在玩的pix2pix,則是使用256*256畫素進行訓練

我使用免費的 FastStone Image Viewer 進行批次裁切、壓縮圖片

FastStone Image Viewer 官網下載頁面

http://www.faststone.org/FSViewerDownload.htm

下載並安裝好之後,桌面會出現捷徑,詳細操作步驟如下

1. 用 FastStone Image Viewer 開啟圖片

1-1 需要批次轉檔的圖片,都放在一個資料夾中

1-2 選資料夾中其中一張圖片,拖曳到桌面 FastStone Image Viewer 的捷徑上

2. 開啟批次轉換功能小視窗

2-1 按F3

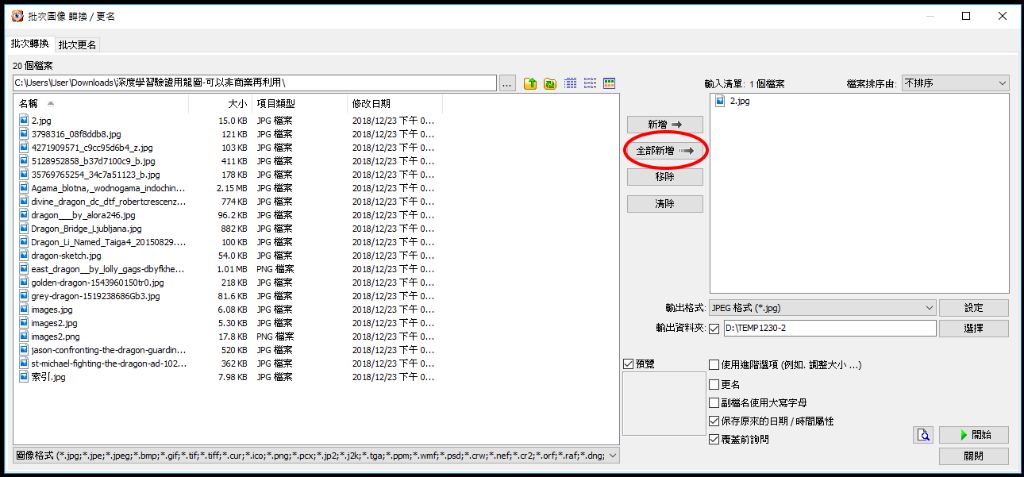

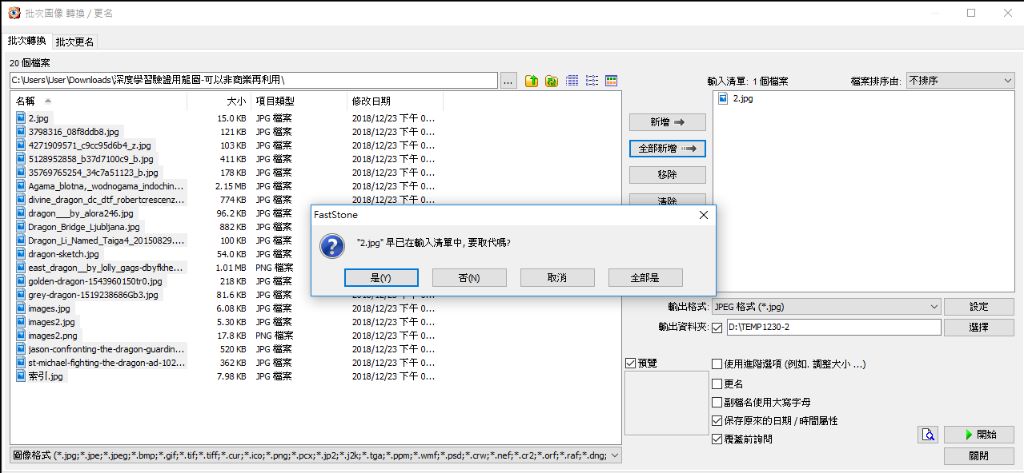

3. 全選整個資料夾的圖片

3-1 按「全部新增」

3-2 因為已經有一張圖片,所以會出現取代警告,按是或否都行

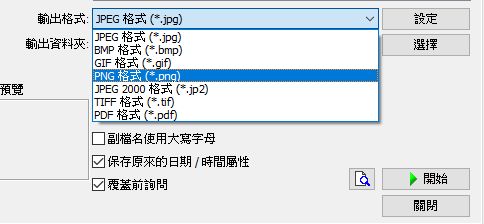

4. 調整輸出格式

4-1 配合pix2pix程式,選擇png。備註:jpg我試過,會出問題,無法訓練

5. 指定輸出資料夾

5-1 檔案路徑和資料夾名稱可自選

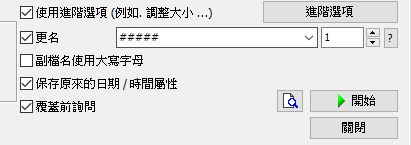

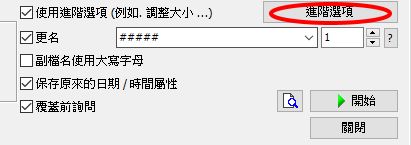

6. 啟用進階選項和更名

6-1 勾選「啟用進階選項」

6-2 勾選「更名」。備註:能將圖片名稱轉換成漂亮的流水號,也能避免test.jpg轉換成png時,和test.png出現檔名衝突問題

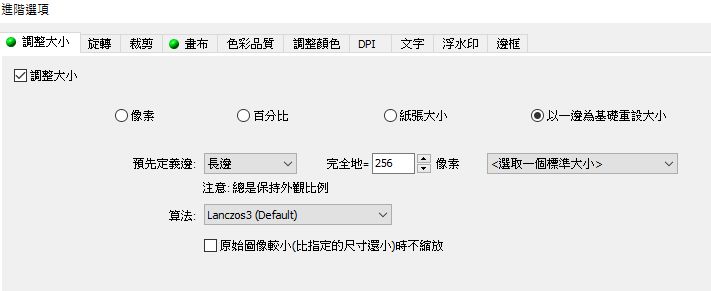

7. 調整大小

7-1 按「進階選項」

7-2 按「調整大小」分頁

7-3 「調整大小」前的框框打勾

7-4 選「以一邊為基礎重設大小」

7-5 設定長邊完全等於256像素

8. 圖片短邊補上黑色

8-1 按「畫布」分頁

8-2 「畫布大小」前的框框打勾

8-3 選「像素」

8-4 新畫布寬度 256

8-5 新畫布高度 256

8-6 背景顏色選黑色

9. 開始轉換

9-1 按確定

9-2 按開始

有 1 位朋友喜欢这篇文章:龙游踏尘

#7036 [TensorFlow]使用pix2pix將灰階圖轉換成彩色圖 » 2018-12-31 21:52:16

回应:

似乎是的,訓練用圖片各種顏色都有,但我沒統計暖色系比例

#7037 [TensorFlow]使用pix2pix將灰階圖轉換成彩色圖 » 2018-12-31 21:11:39

回应:

好像比較偏暖色系?

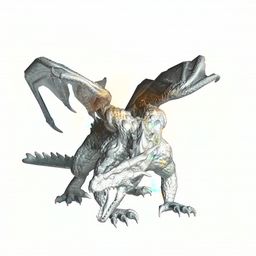

#7038 [TensorFlow]使用pix2pix將灰階圖轉換成彩色圖 » 2018-12-31 10:08:25

回应:

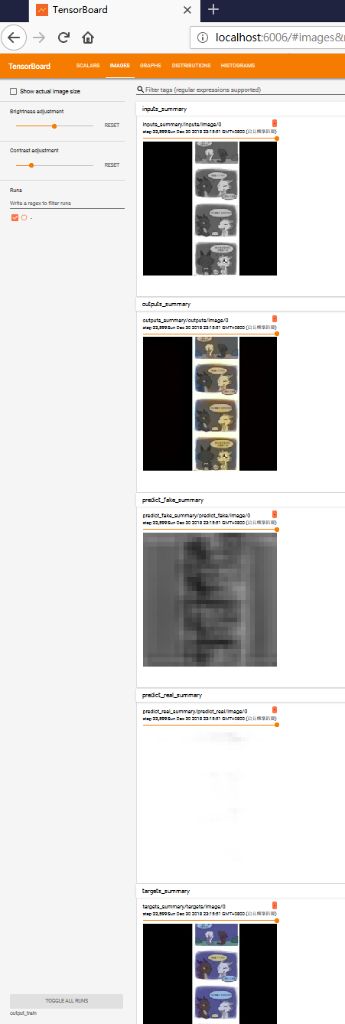

第二次訓練完成

我先解釋一下第二次的訓練用圖片和第一次的差別

首先,這個深度學習的程式只接受256*256畫素的正方形圖片

第一次訓練時,我將長邊切掉,像這樣:

第二次訓練時,我在短邊補上黑色,像這樣:

我發幾張讓大家看看這一次的訓練結果,詳細結果請點下方我的小網站的連結

輸入圖

輸出圖

原始圖

看樣子,灰階圖沒畫好的部分,電腦上色也會不好

輸入圖

輸出圖

原始圖

最讓我驚喜的是這一張,上色結果非常接近原圖

輸入圖

輸出圖

原始圖

驗證用圖片我不是從訓練用圖片中抓的,是另外下載的

因為這一張,我還特地略看了整組訓練用圖片,應該是沒有這一張

所以這真的是AI學習的結果,真是太神奇了 ![[驚訝]](/forum/img/smilies/haku/haku-suprise.svg)

下次訓練,將圖片增加到10萬張以上吧 ![[傻笑]](/forum/img/smilies/haku/haku-simper.svg)

附上目前的三次訓練結果

1. 訓練圖切掉長邊,訓練到70 (max_epochs = 70)

https://www.leisurelywing.synology.me/tensorflow/pix2pix/20181224/

2. 訓練圖短邊補黑色,訓練到13時意外中斷 (epochs = 12)

https://www.leisurelywing.synology.me/tensorflow/pix2pix/20181230/

3. 訓練圖短邊補黑色,訓練到70 (max_epochs = 70)

https://www.leisurelywing.synology.me/tensorflow/pix2pix/20181231/

這一次我也學會叫出訓練曲線來看

雖然這曲線我看不大懂,但上下幅度很大,深色線條是取平均、平滑後的結果

我猜上下幅度大,代表AI還沒找出很好的規律

這一次的訓練用龍圖,可能風格太散,每一張對電腦來說都是特例的話,畫風很難找出規律

下次訓練時,相同風格的多弄幾張好了

有 1 位朋友喜欢这篇文章:shiningdracon

#7040 [TensorFlow]使用pix2pix將灰階圖轉換成彩色圖 » 2018-12-30 18:31:28

回应:

今天下午嘗試用我的主力電腦對同樣的3000多張龍圖進行訓練

顯示卡是1070ti,預計時間約380分鐘,跟之前相比快了好多倍

i7 9700K,預計3000多分鐘

GTX 750ti,預計1300多分鐘

執行到第13輪訓練時,我想說網路上說訓練過程中,隨時可以進行驗證,我就試試看

然後記憶體不足(我有16G),驗證和訓練的工作階段都掛了 ![[被炸]](/forum/img/smilies/haku/haku-bombed.svg)

後來我測試,只驗證256*256的一張圖,居然GPU瞬間100%,CPU瞬間約20%,顯卡記憶體使用約6G

看樣子驗證圖片也需要大量的運算資源 ![[汗]](/forum/img/smilies/haku/haku-embarrassed.svg)

暫停tensorflow訓練有一定的步驟,我也不知道我這樣能不能繼續從13輪開始訓練

不過倒是得到一個只訓練13輪的AI,我將驗證圖發過來給大家看看 (作為對比,我上面4樓的圖,是訓練70輪的AI)

補充說明:

因為訓練只接受256*256大小的圖片,之前的訓練是將長邊切掉變成正方形,

這一次的訓練則是將短邊補上黑色變成正方形,所以嚴格意義來說這次的驗證結果跟上次的驗證結果不能直接比較。

(這個13輪AI倒是很給面子,將我的臨摹圖上了不少顏色 XD)

最后修改: 龍爪翻書 (2018-12-30 18:41:43)

有 1 位朋友喜欢这篇文章:shiningdracon

#7041 年末最後一畫 同時是第一畫.. » 2018-12-30 17:50:31

回应:

話說再反應個問題 換頭像的時候出現的

有 11 位朋友喜欢这篇文章:龍爪翻書, MorksAllen, YellowBamboo, 地球遗龙, shiningdracon, dragon1475632, 龙游踏尘, ken1882, tree-sway, 卷册龙, Melayery

#7042 旭日龍影 » 2018-12-30 17:41:49

回应:

影子超帥

#7044 旭日龍影 » 2018-12-30 17:37:02

#7045 旭日龍影 » 2018-12-30 16:32:25

回应:

兇惡的影子,WOW~

#7046 旭日龍影 » 2018-12-30 10:58:29

回应:

送給影汁的(生日新年聖誕)賀圖+年末總結 (全都一起了超懶 ![[被炸]](/forum/img/smilies/haku/haku-bombed.svg)

有 10 位朋友喜欢这篇文章:Nemiriz, MorksAllen, YellowBamboo, 龍爪翻書, shiningdracon, 沉默の龙, 焰鱗, 龙游踏尘, ken1882, tree-sway

#7047 我對龍族文明的想像 » 2018-12-29 22:54:59

回应:

@shiningdracon 寫道: 說一說我的思考框架:個體

我曾(至現在)也試着做這種框架(並且想做超大的),但現在學業挺緊張的所以很多點都是零散的。影子老師整體 發散的思維很值得學習呀

#7048 《龍之心》第五部開拍?環球推出《龍之心》系列合集dvd » 2018-12-29 19:23:25

回应:

第三部收入很高嗎?

爪機版

爪機版 一爪一天地,一鳞一世界

一爪一天地,一鳞一世界

![[有愛]](/forum/img/smilies/haku/haku-love.svg)

![[壞笑]](/forum/img/smilies/haku/haku-smirk.svg)